Was damals 1968 Stanley Kubrick in seinem Film »2001: eine Space Odyssee« mit dem Computer HAL1 skizzierte, ist heute mit Alexa, Siri & Co. eine technische Selbstverständlichkeit. Maschinen können sprechen und verstehen, sie entwickeln immer mehr Biointelligenz. Natürliche Prozesse und technische Abläufe verschmelzen. Und das fasziniert mich bereits seit dem Studium. Diese Faszination sorgte auch dafür, dass ich irgendwann die zwei – für mich wichtigsten – Dokumente in die Hand bekam: Roberto Pieraccinis Buch »The Voice in the Machine« und einen Funktionsplan des Amazon Echo (einer Alexa-Implementierung). Das Buch eröffnete mir die Frage, wie wir mithilfe von Spracherkennung die Produktivität, z.B. in einer Fabrik, erfassen können und der Funktionsplan gab mir eine Idee, wie dies automatisiert umgesetzt werden kann.

1Unnützwissen: nutzt man jeweils den folgenden Buchstaben im Alphabet, dann wird aus HAL → IBM *shocker*

Die Grundidee: Maschinen können sprechen

In der weiteren Recherche bin ich auf folgenden Ansatz gestoßen, der für mich aufgrund seiner Schlüssigkeit und Einfachheit der interessanteste Perspektivenwechsel ist. Anhand des folgenden Beispiels eines Förderbands möchte in den Ansatz veranschaulichen.

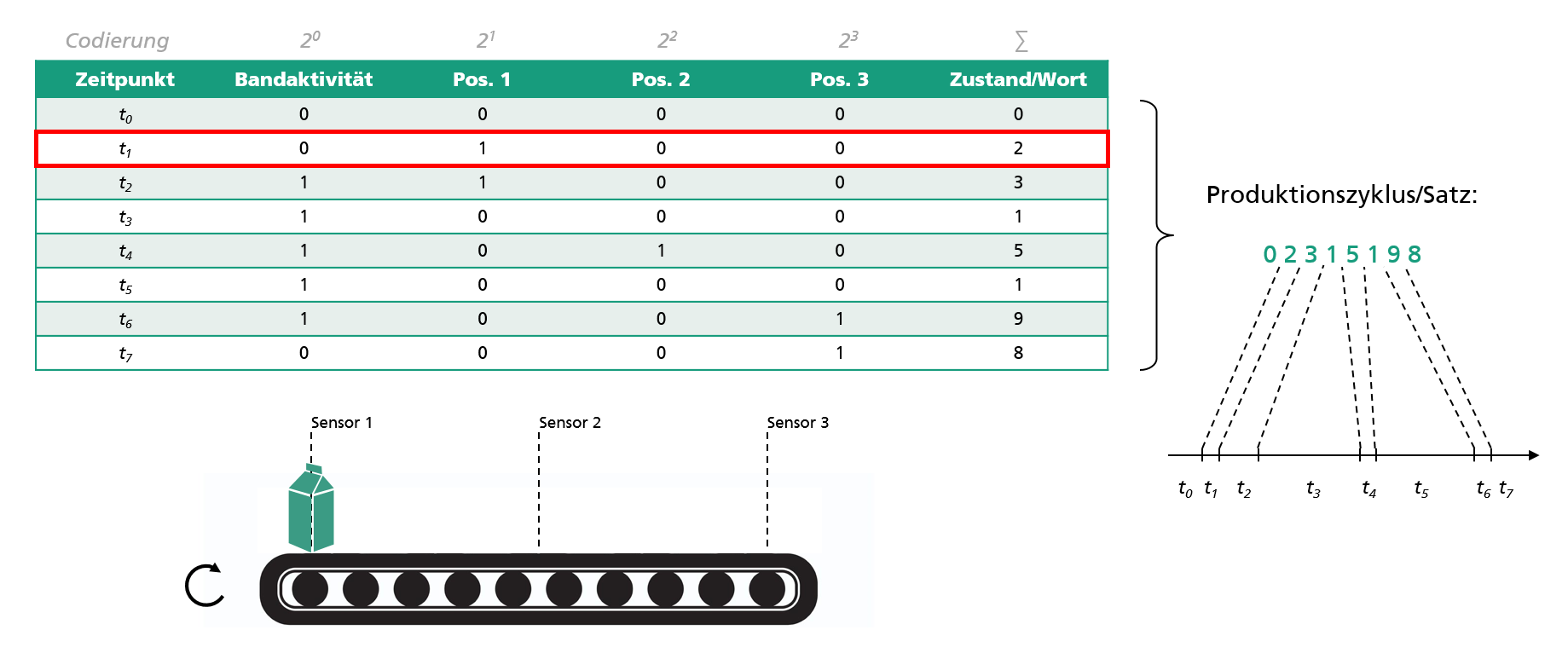

Ein Förderband, das von einer speicherprogrammierbaren Steuerung (SPS) betrieben wird hat vier Signale: Drei Sensoren-Signale (z.B. Lichtschranken), die rückmelden, ob sich an jeweiliger Position ein Gegenstand befindet, und ein Signal, das die Information darüber gibt, ob das Förderband aktiv ist oder nicht. Die Logik hinter der Steuerung ist simpel: Befindet sich ein Gegenstand an Sensor 1, wird das Band aktiviert (Zeitpunkt t1 in der Tabelle), bis der Gegenstand von Sensor 3 erfasst wird und das Band wieder zum Stillstand kommt (Zeitpunkt t6).

Codiert man jetzt die Signale zu jedem Zeitpunkt (Beispielsweise durch eine Binärkodierung) so kann man aus dem Signalvektor von t2: [1, 1, 0, 0] den Zustand 3 = 1*20 + 1*21 + 0*22 + 0*23 eindeutig bestimmen. Mit dieser Vorgehensweise kann jeder Schritt als Zustand beschrieben werden. Eine Abfolge von Prozessschritten ist somit nichts anderes als eine Folge von Zuständen.

Und wie kann damit die Produktivität erhöht werden?

Der für mich interessante Teil der Spracherkennung ist die Tatsache, dass unabhängig von Dialekt, Modulation oder Tonalität Amazon Echo z.B. fähig ist, einen Satz zu identifizieren. Sprich, es wird die kognitive Leistung erbracht, in einem akustischen Signal ein Muster zu erkennen, das sowohl semantische Regeln (inhaltliche Korrektheit, Sinnhaftigkeit) als auch syntaktische Regeln (Grammatik) befolgt – crazy! Somit kann jeder gesprochene Satz, der hinsichtlich des Dialekts, der Modulation und Tonalität in unterschiedlichster Ausprägung erscheinen kann, auf einen geschriebenen Satz zurückgeführt werden.

Für die Produktivitätsoptimierung kann diese Fähigkeit der Identifikation und Interpretation von Abweichungen wie folgt genutzt werden:

- Ein Signalzustand kann als Wort angesehen werden

- Ein Produktionsablauf kann als Satz gesehen werden

- Die Soll-Abfolge eines Produktionsablaufs ist ein geschriebener Satz

- Die Ist-Abfolge eines Produktionsablaufs ist ein gesprochener Satz

- Abweichungen zwischen Soll- und Ist-Abfolge sind Produktionsverluste, die mit diesem Ansatz identifiziert und interpretiert werden können.

Folglich »hört« man bei einem automatisierten Produktionsprozess wiederkehrend denselben Satz, immer und immer wieder. Allerdings nur solange alles planmäßig verläuft. Bei Unregelmäßigkeiten und Veränderungen verändert sich der Satz und wir erkennen wann und was nicht stimmt.

Unser Fokus Natur und Technik verstehen einander – im wahrsten Sinne des Wortes

Der beschriebene Ansatz ist nicht neu. Und der Grund, weshalb er noch keine breite Anwendung gefunden hat, ist einfach erklärt. Im Gegensatz zur Sprache gibt es kein allgemein gültiges Regelwerk (Modell), das auf Produktionssysteme angewendet werden kann. Um im Kontext der Spracherkennung zu bleiben: Jedes Produktionssystem spricht seine eigene Sprache. Folglich ist es nur logisch, dass erste Implementierungen dieses Ansatzes auf Expertenwissen basieren: Eine Person, die ein hohes Verständnis sowohl für das Produktionssystem als auch für die Produkte besitzt, modelliert die systeminhärenten Zusammenhänge mithilfe von Signalen, deren Relevanz es gilt, ebenfalls zu identifizieren. Dieser expertenbasierte Ansatz ist praktikabel, solange keine direkten Veränderungen, z.B. durch Instandhaltungsmaßnahmen, oder indirekte Veränderungen, z.B. durch Produktvarianten, am Produktionssystem durchgeführt werden. Wenn doch, dann muss man dieses Modell neu erstellen. Mit dieser straffen Bedingung wäre dann auch das Problem umrissen: Maschine und Mensch sollen – gesteuert über Sprache – gemeinsam optimal produzieren können

Genau hier setzen wir mit unserer Kompetenz als Gruppe Autonome Produktionsoptimierung am IPA an: Wir arbeiten daran, dieses Modell – das Verhaltensmodell des Produktionssystems – automatisiert zu erstellen, sodass wir den oben vorgestellten Ansatz zur Identifikation und Interpretation von Produktivitätsverlusten nutzen können.

Verfolgen Sie unseren Stand der Entwicklung sowie Referenzprojekte mit industrieller Anwendung auf www.ipa.fraunhofer.de/produktionsoptimierung.

Danke für Ihre Aufmerksamkeit – over and out!